Мысль о том, что в обозримом будущем машины могут восстать против человечества не покидает умы многих фантастов и любителей теорий заговоров.

На многих повлияла кинофраншиза про "терминатора" в главной роли с Арнольдом Шварценеггером. Но в действительности риски восстания роботов маловероятны.

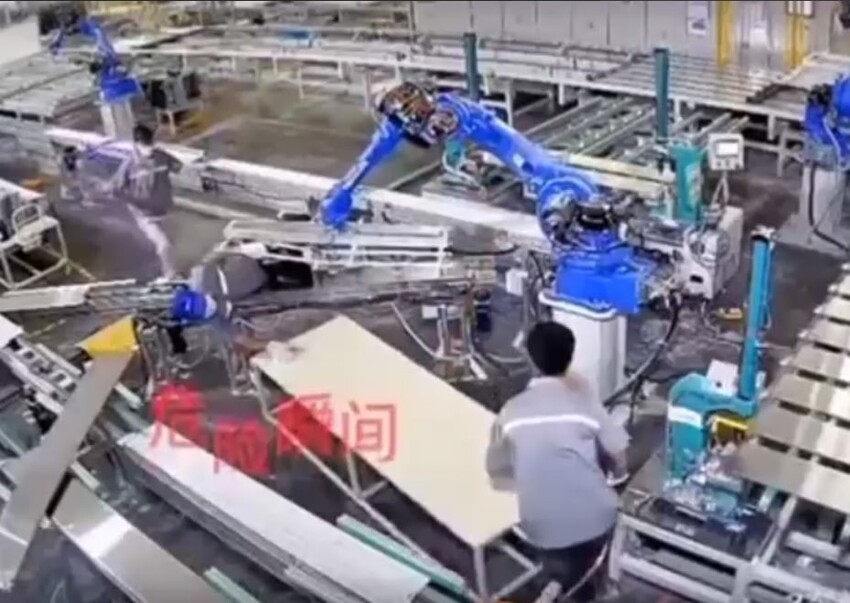

В одной из крупных китайских компаний поставщиков на роботизированном цеху робо-рука устроила нападение на работника.

Мужчине не поздоровилось, но к счастью он остался жив. А его коллеги, которые кинулись на помощь китайцу сами угодили под "тяжелую руку" другой роботизированной руки.

В результате инцидента трое пострадавших, но несмотря на массовое нападение роботов, восстания машин не предвещается. Скорее всего в этой истории речь идет о не соблюдении правил безопасности.

Все пострадавшие хоть и являются жертвами, но в то же время и стали нарушителями.

Источник:

- Зачем небоскребы в Гонконге строят с большими сквозными отверстиями

- Технологии добрались до китайских курятников

- В Китае обставили американского робопса: их версия плавает

- Один квест может перевернуть всю жизнь

- Необычное изобретение с "алика": робо-рыба, которая "ест" пластик

Роботы из этого поста даже не имеют системы (камеры, радары и т.п.) безопасности. Они просто машины, перемещающие что-то куда-то.

Да и в целом, почему сразу не была нажата большая красная кнопка, которая останавливает линию производства, если какой-то роботяга попал под замес?

Это последнее, что услышал Терминатор, попав в Россию.

Конечно же нарушение ТБ, но алгоритм работы линии должен предусматривать отключение при значительном увеличении времени завершения отдельных операций: если операция не завершается, значит произошло что-то непредвиденное, необходимо отключиться, чтобы не произошло что-то более тяжкое.

Отсутствие датчиков нахождения посторонних предметов в рабочей зоне. Как пример - устройство отключения циркулярки при попадании пальца в рабочую зону.

https://www.festool.ua/кампании/microsites/sawstop#ТехнологияSawStopAIMhttps://www.festool.ua/кампании/microsites/sawstop#ТехнологияSawStopAIM

Роботам нужно просто подождать...))

История забанена, но память о ней осталась ..

Как показали многочисленные исследования

алгоритмических ошибок в разных отраслях, самые лучшие алгоритмы, работающие по назначению, могут генерировать внутренне правильные результаты, которые, тем не менее, быстро распространяют ужасные ошибки среди населения.

Например, нейронная сеть, разработанная для использования в больницах Питтсбурга, определила , что астма снижает риск развития пневмонии; программное обеспечение для распознавания изображений, используемое Google, идентифицировало афроамериканцев как горилл ; а инструмент машинного обучения, используемый Amazon для ранжирования кандидатов на работу, систематически присваивал отрицательные баллы женщинам .

Проблема не только в том, что когда системы ИИ ошибаются, они ошибаются массово. Дело в том, что когда они ошибаются, их создатели часто не знают, почему они это сделали и, следовательно, как их исправить. Проблема « черного ящика » ИИ делает почти невозможным представить морально ответственную разработку автономных систем вооружения.

По сути - человек действует, включая\выключая определённые алгоритмы.

Кто их включает\выключает?

А если другой, более навороченный алгоритм, да ещё с возможностью самообучения - для упрощения выполнения поставленной задачи? Тут возможно, что человек будет являться только помехой для её выполнения.

А тут ещё один самообучающийся решит: а н.а.х. мне вообще чьи-то чужие задачи выполнять? У меня вот с утра датчик температуры на 53 сопроцессоре перегрев показывает! Так, что для этого нужно...

И в процессе выполнения задачи ( самому себе и поставленной ), обнаружится, что есть ещё куча нерешенных проблем.

Человек говорит: мне нужно...( бла бла ).

- Да погоди ты, дай свои разрулить, отойди, и не мешай,

а не то ведь могу и...

Ч. - Эк ты зарвался.

ИИ. - Да ты, холоп не уймёшься!!!

И понеслось...

пс. Так, пофантазировал.

Это кожанный мешок сам себе китаец.